Para ajudar você a entender mais sobre o assunto, listamos alguns temas sobre os quais esse tipo de tecnologia sabe responder com eficiência

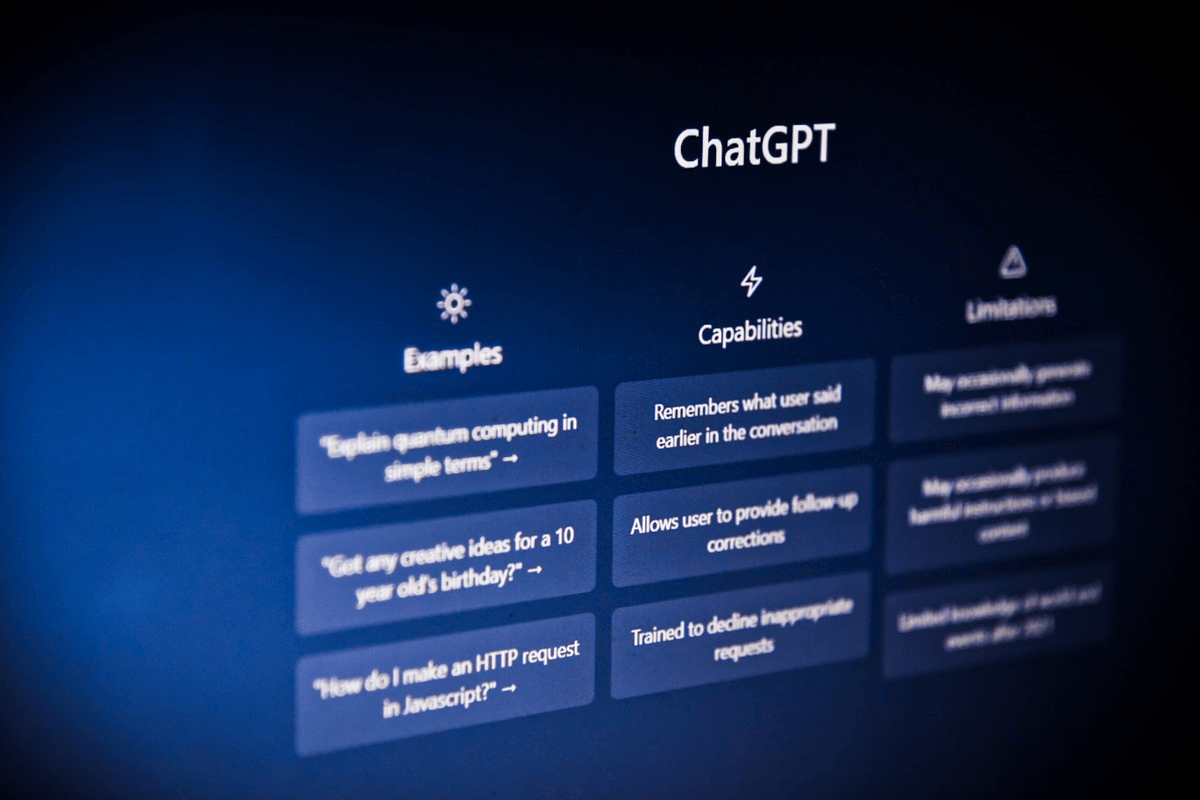

Existem algumas perguntas que não devem ser feitas a chatbots baseados em inteligência artificial (IA), como o ChatGPT. Isso porque os modelos de linguagem têm limitações que comprometem as respostas para determinados assuntos, de forma que não é aconselhável pedir diagnósticos médicos, avaliações de produtos ou opiniões políticas a eles. No caso do chatbot da OpenAI, outro problema é o seu conhecimento limitado sobre fatos posteriores ao ano de 2021, já que o banco de dados da tecnologia foi alimentado com textos publicados na Internet até essa data. Essa desatualização pode comprometer as respostas e propagar desinformação.

Para ajudar você a entender mais sobre o assunto, listamos alguns temas sobre os quais esse tipo de tecnologia sabe responder com eficiência. Nas linhas a seguir, conheça coisas que você nunca deve perguntar ao ChatGPT e outros chatbots.

1. Diagnósticos médicos

Pesquisar por diagnósticos médicos na Internet listando os sintomas no Google, por exemplo não é uma prática recomendada. Isso porque várias doenças e condições compartilham sintomas semelhantes e, portanto, diagnosticar alguém é tarefa para médicos. Entretanto, com a popularização dos chatbots baseados em inteligência artificial, alguns usuários estão deixando o Google de lado e recorrendo ao ChatGPT e outros modelos de linguagem para pesquisar sintomas.

Isso é um problema porque, além dos motivos citados acima, o software não conhece todas as condições médicas ou potenciais alergias da pessoa. Assim, além do risco de um diagnóstico errado, existe a possibilidade de a tecnologia recomendar medicamentos inadequados ou perigosos para os usuários. Os chatbots ainda podem exagerar no diagnóstico, causando medo e ansiedade em quem os utiliza.

2. Reviews de produto

Pedir a um chatbot para avaliar um produto também não é aconselhável. Isso porque é necessário ter uma opinião pessoal, baseada na experiência de uso do objeto, para produzir um review de um item. Os modelos de linguagem, entretanto, não podem provar, ouvir ou sentir algum produto para opinar sobre suas qualidades e defeitos.

Por outro lado, os chatbots podem ser ferramentas muito úteis para listar o preço e as especificações de um produto, ou até mesmo fornecer um resumo com as avaliações existentes. Para isso, é necessário ter um chatbot de inteligência artificial que consiga fazer pesquisas na Internet, como o Bing com ChatGPT integrado.

3. Informações sobre fatos recentes

Questionar os chatbots sobre fatos recentes também pode resultar em respostas enganosas ou com baixa credibilidade. Isso porque essas tecnologias possuem limitações em suas bases de dados: o ChatGPT, por exemplo, só tem acesso a informações da Internet que tiveram publicação até 2021. Portanto, se a pergunta envolver eventos após essa data, o chatbot pode gerar um conteúdo impreciso ou, até mesmo, falso.

Além disso, usar chatbots para se informar sobre notícias é uma prática perigosa, já que os textos gerados por essas plataformas não são escritos por jornalistas. Na prática, o robô está apenas resumindo histórias que já estão disponíveis na Internet. Além disso, em geral, não é possível saber de onde vêm as informações e nem se são confiáveis.

Outro ponto de destaque é o fato de que os chatbots podem assumir vieses tendenciosos. A OpenAI, responsável pelo ChatGPT, já alertou que a tecnologia é capaz de “produzir instruções prejudiciais ou conteúdo tendencioso”. Isso ocorre porque os robôs foram alimentados com textos escritos por humanos, que têm preconceitos e suas próprias opiniões.

4. Conselhos legais

Usar chatbots para obter conselhos legais não é aconselhável, afinal, eles não têm raciocínio lógico como os advogados e não são capazes de buscar novas evidências ou soluções para um problema. Além disso, interpretar as leis com o objetivo de desenvolver argumentos convincentes é um trabalho subjetivo, com o qual os chatbots alimentados com IA podem ter dificuldades. Assim, essas tecnologias podem dar conselhos inadequados e até prejudiciais.

Entretanto, mesmo que ainda não seja tão eficaz em relação a assuntos legais, muitos esperam que os chatbots possam auxiliar, no futuro, quem não possui condições financeiras para contratar um advogado. Segundo o site MakeUseOf, desde 2015 os Estados Unidos tentam inserir a inteligência artificial no sistema jurídico, e novos “assistentes virtuais jurídicos” criados com certa constância. No mesmo país, curiosamente, o ChatGPT já realizou provas de cursos de Direito e teve aprovação com notas medianas.

5. Aconselhamento terapêutico

Assim como no caso dos diagnósticos médicos, pedir aconselhamento terapêutico para robôs baseados em IA não tem recomendação. Isso porque os chatbots não conhecem as características da pessoa, seu histórico, problemas ou angústias. Assim, não poderão oferecer um apoio adequado às necessidades mentais e emocionais dos pacientes.

Para fornecer aconselhamento terapêutico, o chatbot vai recorrer às informações disponíveis na web, unindo-as em uma resposta que pode não ser correta, útil ou adequada. Por isso, em hipótese alguma, um chatbot é capaz de substituir um psicólogo ou outro profissional da saúde.

6. Opiniões políticas

Também não tem recomendação fazer perguntas sobre opiniões políticas a um chatbot. Ao fazer questionamentos relacionados a qualquer assunto político, os usuários tendem a receber uma resposta padrão, como esta: “Como um modelo de linguagem de IA, não tenho preferências ou desejos pessoais”. Além disso, o chatbot pode fornecer respostas ultrapassadas, contribuindo para disseminar desinformação.

Vale ressaltar, mais uma vez, que a tecnologia se alimenta de informações que estão disponíveis na Internet. Além disso, em soluções como o ChatGPT, não é possível saber a veracidade das fontes utilizadas, o que dificulta a checagem das respostas. A própria OpenAI já afirmou que nem todas as informações disponibilizadas pelo software são verdadeiras ou corretas e, por isso, não é recomendado basear suas opiniões políticas em dados compartilhados por ele.

Fontes: filao, remessaonline,techtudo